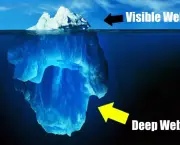

A Deep Web representa toda a forma de conteúdo que não está presente na superfície da Web, ao qual acontecem as indexações por padrão motores de busca. O conceito não deve ser confundido com a “internet escura”. Computadores que já não podem alcançar a Internet com compartilhamento de arquivos de rede distribuída Darknet. Neste sentido ela deve ser classificada como uma parte menor do Deep Web. Mike Bergman, fundador da BRIGHTPLANET, disse que a procura na internet hoje pode ser comparada a uma rede de arrastar ao longo da superfície do oceano: Grandes negócios são encontrados na rede, mas não há uma riqueza de informações profundas. A maioria das informações na Web está enterrada longe dos sites famosos que são gerados dinamicamente e de motores de busca padrão.

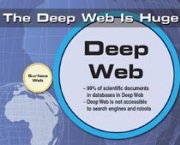

Motores de busca tradicionais não podem “ver” ou recuperar o conteúdo no fundo das páginas que sejam criados dinamismos como o resultado de pesquisa específica. A Web profunda simboliza várias ordens de grandeza maiores do que a Web superfície. Estimativas baseadas em extrapolações a partir de um estudo feito na Universidade da Califórnia, Berkeley, em 2001, diz que a Web profunda consiste de cerca de 7.500 terabytes. Estimativas mais precisas estão disponíveis para o número de recursos na Web profunda. O mesmo estudo detectou cerca de trezentos mil sites profundos em toda a Web, em 2004. O primeiro uso do termo específico Web profunda, agora geralmente aceite, ocorreu no referido estudo Bergman no ano de 2001.

Recursos Profundos da Web

Recursos Profundos da Web Podem ser Classificados em uma ou mais das Seguintes Categorias:

01. Conteúdo Dinâmico: Páginas dinâmicas que são devolvidas em resposta a uma consulta apresentada ou acessada somente por meio de formulário, especialmente quando existem elementos abertos no domínio de entrada (como campos de texto);

02. Conteúdo Desvinculado: Páginas que não estão ligados por outras que podem impedir com quê a Web rasteje os programas de acessar do conteúdo, referido como páginas sem backlinks (ou inlinks);

03. Web Privada: Sites que exigem registro e login (protegidos por senha recursos);

04: Web Contextual: Páginas com conteúdo variável para contextos de acessos diferentes (por exemplo, intervalos de endereços IP de clientes ou sequências de navegação anterior);

05: Conteúdo de Acesso Limitado: Sites que limitam o acesso às suas páginas de forma técnica. Por exemplo, usando o padrão de exclusão de robôs ou cabeçalhos HTTP que proíbem os motores de busca de navegar e criar caches de cópias;

06: Conteúdo Script: Páginas somente acessíveis através de links produzidos por Java Script, bem como conteúdo dinamicamente baixado dos servidores da Web através do Flash ou das soluções Ajax;

07: NON-HTML: Conteúdo textual codificado em multimídia (imagem ou vídeo) com arquivos em formatos específicos não tratados pelos motores de busca;

08: Conteúdo de texto utilizando o protocolo Gopher e os arquivos hospedados em FTP que não são indexados pela maioria dos motores de busca. Motores como o Google somente fazem a leitura de páginas HTTP ou HTTPS.

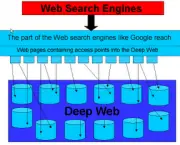

Para descobrir o conteúdo na Web os motores de busca usam buscadores no sentido de seguir o hiperlink com virtuais de protocolos que são conhecidos pelo alto número de acessos. Esta técnica é ideal para descobrir recursos na Web de superfície, mas é muitas vezes ineficaz em encontrar recursos da Deep Web. Por exemplo, esses rastreadores não tentam encontrar páginas dinâmicas que são o resultado de consultas do banco de dados devido ao número infinito de consultas possibilizadas com o recurso. Pesquisadores exploram de maneira contumaz diversas formas no sentido de explorar a Deep Web. Em 2001, Sriram Raghavan e Hector Garcia-Molina são pensadores que apresentaram modelo de arquitetura para rastreador escondido que usou conjunto de termos-chaves fornecido por usuários ou recolhido a partir das interfaces por usuários ou recolhidos a partir das interfaces de consulta para consultar formulário Web e rastrear os profundos recursos da rede.

Motores de busca comerciais começaram a explorar métodos alternativos para rastrear a Web profunda. O Protocolo Mapa (primeiro desenvolvido pelo Google) representa mecanismo que permitem com quê os motores de busca e outras partes interessadas descubram recursos da Web profunda em servidores particulares. Os mecanismos permitem aos servidores da Web anunciar as URLS que são acessíveis a eles, permitindo assim a descoberta automática de recursos que não estão ligados à superfície. Deep Web do Google demonstra sistema que pré-computa submissões para cada formulário HTML. Adicionam as páginas HTML resultante para o índice motor de busca Google. A conta de resultados demonstra o poder de existir mais mil consultas por segundos para o conteúdo da Web profunda. Neste sistema, o cálculo de pré-inscrições é feito usando três algoritmos: (1) a seleção de valores para entradas de texto de pesquisa que aceitam palavras-chave, (2) identificar as entradas que aceitam somente os valores de um tipo específico (por exemplo, data) e (3) seleção de um pequeno número de combinações de entrada que geram URL adequadas à inclusão no índice de busca na web.

Classificação de Recursos

Determinar de maneira automática os recursos entre Web de superfície ou Web profunda simboliza tarefa difícil. Se o recurso é indexado por um motor de pesquisa, não é, necessariamente, um membro da Web de superfície, porque o recurso pode ter sido encontrado em qualquer outro método ao invés do rastreamento tradicional. Quando o motor de busca fornece backlink de um recurso, se imagina que o recurso está na Web superfície. Infelizmente, os motores de busca não são sempre todos os backlinks para recursos.

Mesmo se um backlink existe, não há nenhuma maneira de determinar se o recurso assegurando a ligação acontece por si só na superfície Web sem rastrear toda a Internet. Além disso, um recurso pode residir na Web superfície, mas que não foi ainda encontrado pelo motor de busca. Portanto, se existem recursos arbitrários, não podemos saber com certeza se os mesmos residem na Web ou na superfície profunda sem rastreamento completo do WWW. Para a classificação dos recursos da Web profunda são apresentados algoritmos que classificam site em profundidade à categoria que gera o maior número de visitas para alguns selecionados, com consultas focadas.

Artigo escrito por Renato Duarte Plantier